Content Downloader X1 версии 11.1.0000010 (06.09.2016)

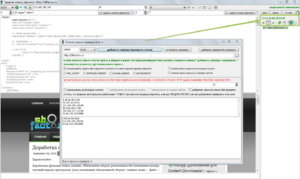

– В инструмент задания границ парсинга добавлена панель управления прокси;

– Несколько других доработок.

В инструмент задания границ парсинга (ctrl+f1) добавлена панель управления прокси

September 6th, 2016 8 коммент. »

Написать комментарий

Пожалуйста, ознакомьтесь с правилами комментирования (причина УДАЛЕНИЯ некоторых комментариев)

Новости RSS

Новости RSS

Рубрики:

Рубрики:  С вопросами о покупке (или другими организационными), вы можете в любое время обращаться по Телефону +7 983 381 3211 или Телеграм @ContentDownloaderX1 (Сергей Владимирович)

С вопросами о покупке (или другими организационными), вы можете в любое время обращаться по Телефону +7 983 381 3211 или Телеграм @ContentDownloaderX1 (Сергей Владимирович)

WBApp (дополнение для Content Downloader) - парсинг с выполнением WEB-скриптов, с возможностью имитации кликов по элементам страниц, произведение прокрутки страниц, заполнение текстовых полей и многое другое...

WBApp (дополнение для Content Downloader) - парсинг с выполнением WEB-скриптов, с возможностью имитации кликов по элементам страниц, произведение прокрутки страниц, заполнение текстовых полей и многое другое...

Сергей, спасибо большое. То что надо.

Здравствуйте.

Пожалуйста.

Добрый день.

Заметил такую вещь.

При использовании прокси, через библиотеку INDY, connection closed gracefulu, а при всех же тех же параметрах, но с библиотекой Clever Internet Suite код документа загружается нормально.

Это окей? или что то не так в программе?

Будет ли версия программы с потоками от 50? лично я готов доплатить за потоки

Здравствуйте!

Планируем сделать!

С уважением к вам, Сергей.

Да, потоков хотелось бы побольше, через прокси идут большие задержки, от чего скорость не получается выше 7 в сек. Без прокси скорость уже упирается в проц. Канал 100 мегабит при этом занят лишь немного. А вот скорость обработки и поиска самих ссылок уже упираются в пределы домашнего ПК. Имею свои сервера, они с легкостью отдают контент в 50 потоков, загрузка сервера при этом не более 15% при самых тяжелых запросах. Отсюда вопрос и предложение, планируется ли сделать чисто 64 битную версию, которая бы с легкостью переваривала любой объём ссылок (часто пользуюсь программой немного не по назначению, фильтрую миллионы строк текста, оч крутой фильтр, но иногда упирается в память, причем 8Гб не спасет както кардинально ситуацию, я так понимаю программа не переваривает более 1,5 Гб инфы в ОЗУ), при этом хочется чтобы программа использовала многоядерность на 100%. На данный момент в загрузке лишь одно ядро((( оч нехватает…. Но прога просто космос. Пользуюсь ей каждый день. Она у меня в ТОП 1.

Здравствуйте.

Спасибо на добром слове!

Пока сложности с многоядерностью и 64-бит версией!

С уважением к вам, Сергей.

Здравствуйте!

Заметил одну важную нехватку в сканере и в окне добавления ссылок.

В программе имеется фильтр на дубль ссылок и на дубль доменов, но очень бы хотелось увидеть кнопочку “Удалить ссылки из файла со списком”. Например у нас сканер нашел 1 млн ссылок, но допустим в прошлый раз он находил часть тех же самых ссылок, их парсинг был успешен. И сейчас уже нет смысла в повторном парсинге. А функция фильтрации дублей не удаляет ранее просканированные url. Хотелось бы увидеть кнопочку с выпадающим окном или указанием файла со списком ссылок которые не нужно добавлять, точнее, их нужно удалить/отфильтровать. Теоретически это можно сделать в фильтре ссылок “не добавлять ссылки содержащие”, но там идет поиск на неточное совпадение, а хотелось бы на точное. К тому же скорость такого фильтра врядли позволит из 1 млн строк найти и отфильтровать скажем 100 тыс ненужных.

Данной функции постоянная нехватка… очень хотелось бы увидеть.

Огромная благодарность за постоянные обновления и улучшения!